Les internautes ne “cherchent” plus, ils montrent.

Et Google s’y prépare avec le lancement de son nouveau Google Lens AI Mode — une évolution majeure de la recherche visuelle.

Ce mode ne se contente plus d’identifier une image, il la comprend.

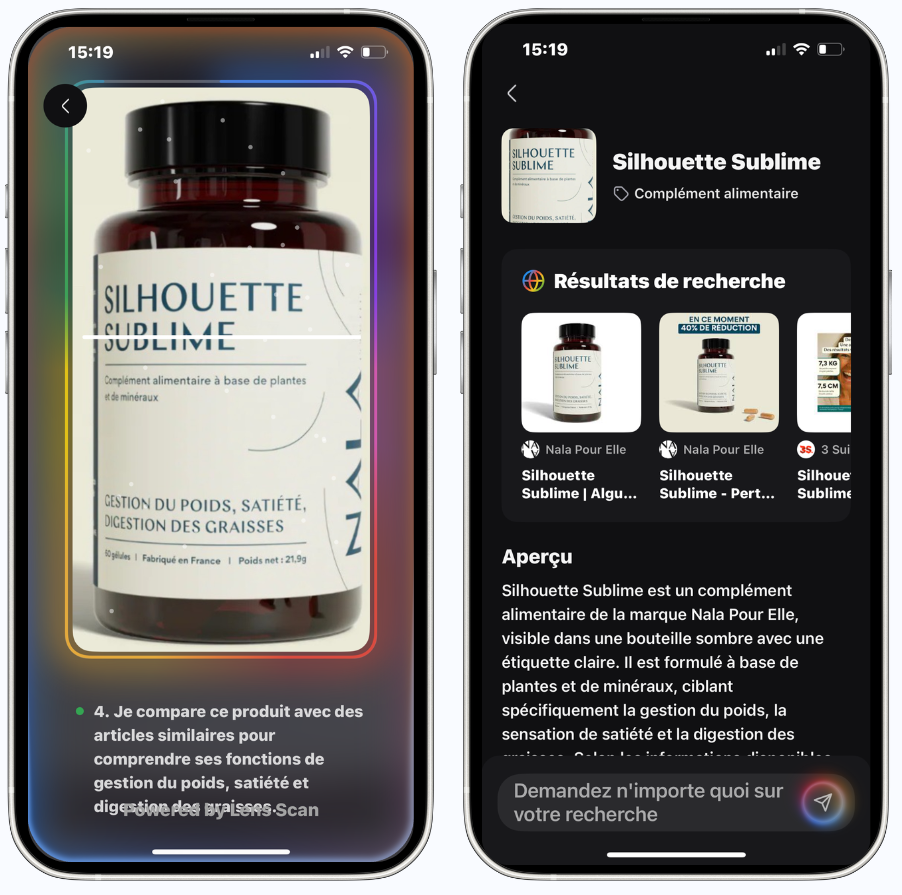

Concrètement, vous montrez un objet, une scène ou un produit… et l’IA de Google ne se contente plus de le reconnaître.

Elle vous dit ce que c’est, à quoi il sert et où l’acheter.

➡️ Une révolution silencieuse, mais lourde de conséquences pour le e-commerce.

Pourquoi la recherche visuelle atteignait ses limites

Depuis 2017, Google Lens permettait déjà de traduire un texte, reconnaître une plante ou retrouver un produit.

Mais son usage restait “passif” : on montrait une image pour obtenir une information, sans réelle interaction.

Le problème ?

Aucune interprétation du contexte, donc peu de valeur commerciale.

Les marques n’y voyaient qu’un gadget ; les utilisateurs, un outil pratique mais sans profondeur.

Le AI Mode vient corriger ça.

Pour la première fois, Google ne veut plus seulement voir vos images : il veut raisonner à partir d’elles.

Ce que change le nouveau “Google Lens AI Mode”

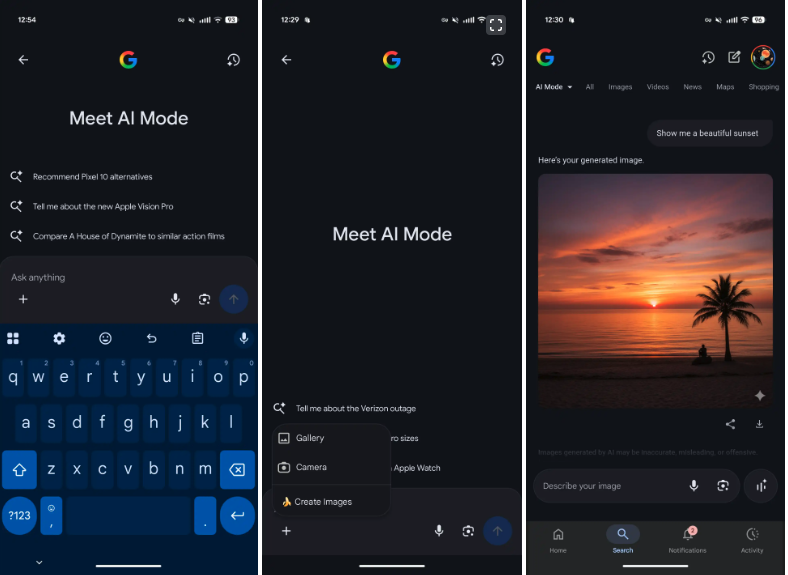

Encore en phase de test, ce nouveau mode — connu en interne sous le nom de code Nano Banana — marque un vrai saut technologique.

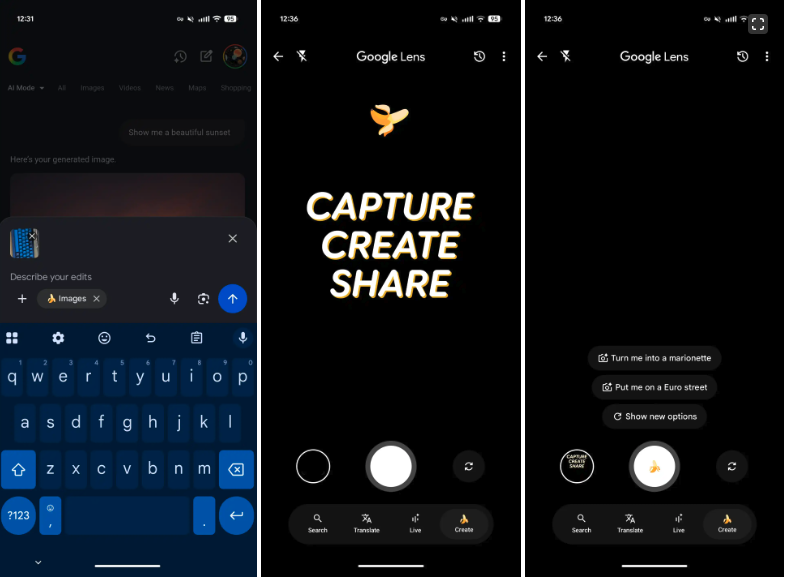

Il ne s’agit pas d’une application séparée, mais d’une évolution directe de Google Lens : Google y intègre désormais ses modèles d’IA générative (Gemini / Imagen) pour permettre à Lens non seulement d’identifier, mais aussi de comprendre et créer à partir de ce qu’il voit.

Autrement dit, la recherche visuelle devient à la fois intelligente et générative.

Google Lens passe du computer vision à la visual reasoning : l’IA analyse la scène et répond en langage naturel.

Exemples :

- vous montrez une plante → “voici comment l’entretenir ; voici un engrais compatible”,

- un vêtement → “voici où l’acheter ou un modèle équivalent”,

- un produit tech → “voici la fiche complète et des alternatives”.

➡️ En clair : Google transforme l’image en intention de recherche.

Et quand il y a intention, il y a conversion possible.

Ce que Google Lens AI Mode change pour les e-commerçants

La recherche visuelle devient un point d’entrée d’achat à part entière.

Les marques visibles dans ces nouveaux résultats ne seront plus celles qui dominent le SEO texte, mais celles qui optimisent leurs signaux visuels et sémantiques.

Quelques règles à retenir :

✔️ Des visuels produits haute qualité, nets, bien exposés, cohérents avec la fiche produit.

✔️ Des données structurées : balises ALT enrichies, titre clair, légende explicite.

✔️ Une présence alignée entre Merchant Center, P-Max, Discover et Google Images.

En résumé :

le visuel devient un signal d’intention, aussi fort qu’un mot-clé.

L’impact du Google Lens AI Mode sur les campagnes SEA / P-Max

Les campagnes P-Max s’appuient déjà sur les assets visuels pour comprendre les produits et générer les annonces.

Google n’a pas encore officialisé de lien direct entre Lens et P-Max,

mais les signaux visuels issus de l’IA — qualité, cohérence, contexte — influencent déjà la notation des assets.

La convergence est donc inévitable.

Autrement dit :

vos images ne sont plus de simples “supports créatifs” ;

elles deviennent de véritables indicateurs de pertinence publicitaire.

→ Une continuité logique avec notre précédent article, Google Ads IA : l’IA crée vos pubs, les juge… et attire les régulateurs.

Google ne se contente plus d’évaluer vos visuels publicitaires :

avec Lens AI Mode, il apprend désormais à les comprendre.

Un visuel mal compressé, flou ou incohérent peut désormais :

→ dégrader la note de qualité,

→ faire grimper les coûts d’enchères,

→ réduire la visibilité produit.

L’ère du “visuel décoratif” est terminée ;

place au visuel stratégique.

Du visuel à l’achat sans mots-clés : le nouveau parcours utilisateur

Les jeunes générations ne tapent plus “chaussures blanches Nike 37”.

Elles prennent une photo, ou un screenshot Pinterest.

C’est ce qu’on appelle la recherche sans mots-clés.

Google, longtemps en retard sur cette tendance face à TikTok, Pinterest ou Snapchat,

revient avec une approche radicale :

unifier Search + Shopping + Discover dans un seul geste :

je montre → je comprends → j’achète.

Pour les marques, cela change tout :

- Les visuels deviennent des portes d’entrée d’acquisition.

- La cohérence esthétique d’un catalogue influe sur la performance.

- La notoriété visuelle compte autant que la notoriété sémantique.

Autrement dit : on n’optimise plus seulement ce qu’on écrit,

on optimise ce qu’on montre.

Comment se préparer dès maintenant :

1️⃣ Auditez vos visuels produits.

Vérifiez leur qualité, leur cohérence et leur compression.

Supprimez les fonds gris, les flous, les duplications.

2️⃣ Structurez vos données.

Utilisez des balises ALT descriptives et uniques, intégrez le schéma Product, synchronisez vos flux Merchant Center.

3️⃣ Optimisez vos assets pour P-Max.

Formats cohérents, ratio 1:1 ou 4:5, textes intégrés lisibles.

4️⃣ Testez Google Lens dès maintenant.

Prenez vos produits en photo : que renvoie Lens ?

Si ce n’est pas vous… c’est un concurrent.

5️⃣ Travaillez votre univers visuel.

Une cohérence forte (lumière, style, fond) aide l’IA à comprendre et classer vos produits.

Objectif : apparaître dès maintenant dans les réponses de recherche visuelle IA,

avant que la fonctionnalité ne devienne mainstream.

Ce que ça change pour le marché

L’arrivée du AI Mode de Lens ne concerne pas que Google.

Elle annonce la fusion progressive entre moteurs de recherche et moteurs d’achat.

Les frontières entre inspiration, recherche et transaction s’effacent.

Les plateformes sociales deviennent des moteurs d’achat.

Et Google, pour rester dominant, doit apprendre à “voir” comme un utilisateur.

Pour les marques, cela signifie :

- plus d’opportunités de capter la demande ;

- mais aussi plus d’exigence : cohérence, qualité, vitesse.

La vision Semseo

Le AI Mode de Google Lens n’est pas une simple évolution produit.

C’est un nouveau tournant dans la façon dont on découvre les marques :

la recherche ne passe plus seulement par les mots,

mais par les images, les objets et les contextes.

Demain, vos produits seront découverts non pas parce qu’ils sont bien positionnés sur un mot-clé,

mais parce qu’ils sont reconnus, compris et cités par les moteurs d’IA.

Le futur du e-commerce sera visuel, contextuel et génératif.

Chez Semseo, on aide les marques à préparer leurs visuels à cette nouvelle lecture algorithmique :

pour qu’elles restent visibles, rentables et choisies,

même quand la recherche devient sans texte.

Prenez rendez-vous avec un expert Semseo pour auditer vos visuels et anticiper cette transition.